Azt hittük, hogy a demokráciát teszi tönkre, de az átlagembert küldi a sírba [18+]

A 2010-es évek a post-truth és a dezinformáció évei voltak, sokan tartottak attól, hogy a demokratikus folyamatokat és politikai vitákat manipulált videókkal fogják hekkelni. Azóta kiderült, hogy van, ami jobban érdekli az embereket a politikánál: a pornó. Hogyan működik a deepfake technológia, és hogyan lehet viszonylag kis ráfordítással valódinak látszó pornóvideókat készíteni teljesen átlagos emberekről is?

![Azt hittük, hogy a demokráciát teszi tönkre, de az átlagembert küldi a sírba [18+]](/userfiles/c/8/c89998aae67566efb0640bcde4620052_thumb_940x527.jpg)

Amióta világ a világ, a politika szereplői sosem ijedtek meg attól, ha piszkos eszközökhöz kellett nyúlniuk a választások befolyásolásához. A történelemben számos példát találunk erre: a legnyíltabb választási csalásoktól kezdve ezek közé tartozik a vesztegetés, a kenőpénzek elfogadása, az ellenfél jelöltjeit célzó negatív kampány is. Főleg az ilyen kampányok eszközeit fejlesztették tökélyre az elmúlt évtizedekben: kiszivárogtatott felvételek kerültek napvilágra, vagy egyenesen hazugságokat terjesztettek az adott jelöltről – esetenként manipulált felvételekkel alátámasztva azokat.

A 2010-es években megjelent egy újabb eszköz, amivel a dezinformációt terjesztők még nagyobb bajt tudnak okozni a demokratikus folyamatokban. Ez a technológia az ún. deepfake. Ez az eszköz nemcsak képek, hanem videók manipulálására is alkalmas. A gépi tanulásra épülő technológia segítségével akár olyan videókat is el lehet készíteni, ahol a képeken látható közszereplő valójában nem is szerepel a felvételen, hanem egyszerűen ráillesztik az arcát.

Nagyon sok vészjósló cikk foglalkozott azzal, hogy miként áshatják alá a demokráciát és a demokratikus folyamatokat az ily módon manipulált, hamis videók. 2020-ra azonban kiderült, hogy a videomanipulációs technikának jelenleg mégsincs akkora hatása a politikára, mint azt az elemzők korábban előrevetítették.

Hogyan működik a technológia?

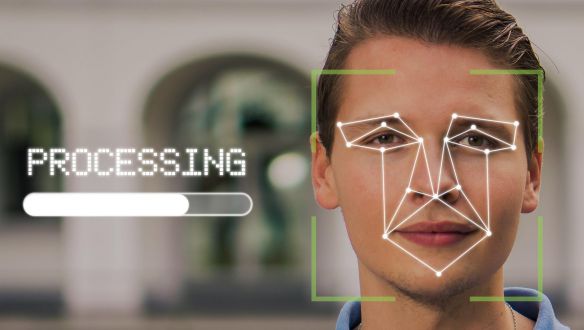

A deepfake fogalmat az olyan kép- és videófelvételek megnevezésére használják, ahol mesterséges intelligencia segítségével manipulálják a felvételeket, hogy olyan egyének arcait helyezzék rájuk, akik valójában nem is szerepelnek ezeken. Maga a kifejezés egyébként a deep learning és a fake szavak egybeolvasztása, azaz a kifejezés mesterséges intelligencia mélytanulására és a felvétel hamis voltára utal.

Ahhoz, hogy egy ilyen képet vagy videót elkészíthessenek, több dolog is kell:

+ egyrészt egy videó, ahova ráilleszthető az egyén arca,

+ nagyon sok, magas felbontásban elkészített kép az egyén arcáról – lehetőleg minél több szögből,

+ egy mesterséges intelligenciát használó program, amivel a felhasználó kicseréli az arcokat.

A mesterséges intelligencia itt is hasonló elven működik, mint az arcfelismerő programoknál: egy arcképen többezer egyedi jelet keres, azonban ezt a felhasználó nem arra használja fel, hogy utána összehasonlítsa egy adatbázisban lévő más arcjegyekkel, hanem hogy rámontírozza a felvételen szereplő arc helyére.

Hogy megértsük, pontosan hogyan készülnek a deepfake felvételek, két rendszer működését kell megértenünk. Az egyik az ún. autoencoder, ami tulajdonképpen a számítógép eszköze az arc feltérképezésére. Az autoencoder megvizsgálja, hogy miként mozog az emberi arc, hogyan lehet azt animálni: szimulálja, hogyan pislogna, mosolyogna és vigyorogna. Ehhez a gépnek több ezer ismertetőjegyet kell felismernie. Az eredmény pontosságához sok felvétel szükséges, hogy a kapott kép vagy videó ne legyen túl homályos az esetleges adathiány miatt. Az autoencoder a bemeneti információkat felhasználva ráhelyezi az alany arcát a manipulált videóra.

A másik rendszer a generative adversarial network (GAN), ami az autoencoder által készített felvételt veti össze az alany valódi arcával. A pontatlan képeket visszautasítja, és további kísérleteket kér az autoencodertől az arc modellezésére, így tökéletesítve a felvételt.

Egyszerűen fogalmazva:

– azaz elég pontos ahhoz, hogy ne akadjon fel a GAN szűrőjén. A rendszernek fontos jellemzője az is, hogy mivel mélytanulás útján sajátítja el a tudást a munkát végző mesterséges intelligencia, így minél több videót készítenek vele, annál pontosabb és hitelesebb lesz a végeredmény. Az utóbbi években ugrásszerűen megnövekedtek a GAN-nal kapcsolatos kutatások.

A folyamat elsőre összetettnek és bonyolultnak tűnik, azonban valójában egyáltalán nem az:

vagy amikor egyszerre ketten szerepeltek egy képen és az arcokat megcserélték. Az ilyen arccserélő appok azonban nem túl pontosak, mivel csupán egy kép alapján próbálják kicserélni az arcokat, így az algoritmusnak nem áll rendelkezésére elegendő információ. Így sokszor csak homályosan tudják végrehajtani a feladatot, mivel a hiányzó adatokat az alkalmazás véletlenszerűen pótolja.

Nagyjából így működik a deepfake technológia is, csak sokkal szofisztikáltabban és sokkal reálisabb végeredménnyel, ennek következtében sokszor elég nehéz eldönteni, hogy a felvétel valójában igazi vagy hamis. Jó példa ez a videó, ahol a humorista Bill Hader arcát Tom Cruise-ra cserélik, amikor épp őt imitálja.

A politika helyett a szórakoztatást szolgálja

A legtöbb deepfake videó egy 2019-es tanulmány szerint egy bizonyos szórakoztatási formában jelenik meg,

A Deeptrace nevű cég tanulmánya szerint az online található deepfake videók 96 százaléka tartalmaz pornót, míg a maradék 4 százalék a manipulált politikai képektől kezdve a viccesnek szánt YouTube-videókon át az „egyéb, nem pornó videók” kategóriához sorolható.

A tanulmány szerint 2018 és 2019 között csaknem duplájára nőtt a beazonosított deepfake videók száma. Nem csak a kínálat, a kereslet is nagy: a tanulmány 2019 szeptemberi publikálásakor a négy legnagyobb, kizárólag deepfake pornóra szakosodó oldal videóit összesen több, mint százharmincmillió alkalommal nézték meg.

Az ilyenfajta videókon akaratuk ellenére szereplők nem egyenlően oszlanak el a két nem között:

A videókon szinte csak a szórakoztatóiparban szereplő nők szerepelnek: az esetek 99 százalékában híres színésznők és zenészek arcait használják fel, azonban van 1 százalék, ahol nem az ő képmásukkal élnek vissza. Ez egyáltalán nem meglepő: a szórakoztatóiparban tevékenykedő nőkről a munkájukból adódóan sok megfelelő minőségű kép áll rendelkezésre.

akik többnyire a „bosszúpornó” áldozatává válnak. Róluk volt barátok, titkos hódolók készítenek vagy készítettnek deepfake pornófelvételeket.

Mivel a technológia gyorsan fejlődik, a programok kezelése egyre felhasználóbarátabb: ennek következtében ma már egy rövid deepfake videót akár 20 dollárért, közel hatezer forintért is meg lehet rendelni ebben utazó emberektől. Egyes tudósítások szerint akár már öt perc alatt is elkészíthető egy ilyen felvétel. Ezeket pedig már nem csak „szórakoztatás” céljából készítik, hanem akár vesztegetésre vagy zsarolásra is fel lehet őket használni.

De miért ilyen könnyű az ilyen videók készítése átlagemberekről?

Ez szintén a technika és a technológia fejlődésének köszönhető. Az arcfelismerő programok fejlődésével a gépek már könnyebben tudnak beazonosítani arcokat, és a deepfake programok mesterséges intelligenciái is sokat fejlődtek az elmúlt évek során. (Az arcfelismerő programokról itt írtunk bővebben.)

A programok fejlődése mellett szintén nagy probléma, hogy sok esetben maguk

nagyon sok információkat tudhatnak meg rólunk olyanok is, akiknek ártó szándékaik lehetnek ezekkel az információkkal. Sok arckép feltöltésével pedig a felhasználók jelentősen megkönnyíthetik a deepfake videókat készítő mesterséges intelligencia dolgát.

Így járt például egy addig ismeretlen, 18 éves ausztrál nő, akinek az arcát eleinte „csak” pornóképekre photoshoppolták rá, de később deepfake videókon is szerepelt az arca, látszólag szexuális tevékenység közben.

Később hiába harcolt, hogy ezeket a videókat és képeket töröljék az oldalakról, azok az interneten újra és újra felbukkantak.

A Deeptrace 2019-es tanulmánya szerint legalább húsz olyan csoport működik az interneten – és akkor még a darkwebről, az alvilág internetéről nem is beszéltünk –, amik deklaráltan deepfake pornóvideók készítésével foglalkoznak. Ezek többnyire a Redditen, a 4chanen, az 8chanen vagy a Voaton hirdetik magukat.

A legnagyobb pornószolgáltatók ugyan küzdenek a deepfake videók ellen, de a tanulmány szerint a 10 legnépszerűbb pornóoldalból 8 oldalon jelen vannak ilyen manipulált videók. Azonban ez a deepfake pornók mindössze 6 százalékát adja: a deepfake felvételek 94 százaléka erre szakosodott oldalakon szerepel.

Bár a pornóoldalak a legtöbb esetben feltüntetik, hogy a videó hamis, azonban ez még továbbra sem jelenti azt, hogy az egész legális lenne: beleegyezésük nélkül „szerepelnek” ilyen videókon az emberek, a valósághű videók pedig akár zsarolásra is alkalmasak lehetnek.

A dezinformáció eszköze a politikában is

A technológiát az esetek 96 százalékában pornóvideók készítésére alkalmazzák, de a maradék négy százalékban is vannak meghökkentő példák. Az egyik leghíresebb ilyen Obama beszéde, ahol Trumpra azt mondta, hogy egy szar alak (dipshit). Azonban, ahogy a lentebbi videóból kiderül, ez is deepfakenek bizonyult: a Buzzfeed kérte fel a humorista Jordan Peele-t a felvétel elkészítésére, amivel a céljuk az volt, hogy felhívják a figyelmet a dezinformáció és a deepfake veszélyeire.

Peele a videóban azt mondja:

De nem csak oktató célzatú videók léteznek. 2018-ban óriási botrányt kavart, amikor Trump egy sajtótájékoztatón megvonta a szót a CNN riporterétől, Jim Acostától: egy fehér házi gyakornok el akarta venni a mikrofont Acostától, de a riporter nem adta oda neki. A botrány tárgya nem Acosta tevékenysége volt, hanem hogy a Fehér Ház akkori szóvivője, Sarah Sanders a saját Twitter-oldalán egy manipulált felvételt közölt az incidensről. Ezen kivágták Acosta hangját, ahogyan elnézést kért a gyakornoktól, és úgy manipulálták a felvételt, mintha meg is ütötte volna a mikrofont kérő gyakornokot.

Ugyan ez a videó nem deepfake, de ugyanúgy dezinformációs céljai voltak, és jól megmutatja, mire képesek a modern kép- és videomanipulációra alkalmas technológiák, és mire lehet ezeket legjobban felhasználni.

Ebben a deepfake videók céljai és a funkciói megegyeznek a többi dezinformációs eszközével.

Jelenleg ez a technológia még nem ért a csúcsra: a semmiből csak nehezen lehet olyan videót manipulálni, amiről lehetetlen eldönteni, hogy a felvételen történtek valódiak vagy sem. A deepfake azonban így is az egyik legkiválóbb eszköz dezinformációs célokra, legyen szó akár a politikai ellenfél lejáratására és hiteltelenítésére gyártott, akár aljas szándékból készített bosszúpornó videókról.

NYITÓKÉP: Vitárius Bence / Azonnali

GRAFIKONOK, ÁBRÁK: Karóczkai Balázs

A cikk technológiai részéhez köszönöm Barták Iván segítségét.

Tetszett a cikk?

Az Azonnali hírlevele

Nem linkgyűjtemény. Olvasmány. A Reggeli fekete hétfőn, szerdán és pénteken jön, még reggel hét előtt – tíz baristából kilenc ezt ajánlja a kávéhoz!

Feliratkozásoddal elfogadod az adatkezelési szabályzatot.